Nir Lahav e Zachariah A. Neemeh hanno scritto nel 2022 un articolo fondamentale dal titolo A Relativistic Theory of Consciousness.

L’ambizione del saggio è duplice: dissolvere lo hard problem della coscienza (sollevato da David Chalmers) e dissolvere anche il problema del carattere privato della coscienza.

Come è noto, Chalmers considera “difficile” il problema di spiegare perché abbiamo una coscienza, dal momento che tutto potrebbe benissimo funzionare identicamente anche se fossimo tutti zombies senza coscienza. Tale tesi deriva dall’assunzione che il nostro funzionamento come sistemi percettivo-cognitivi sarebbe identico anche se non fossimo coscienti. Infatti, se intendiamo che un sistema di questo tipo funzioni egregiamente se risponde agli stimoli/input che gli provengono dall’ambiente “computando” (attraverso il sistema nervoso centrale) comportamenti/output adeguati, che bisogno c’è che a questa macchina meravigliosa si aggiunga anche la coscienza?

La cosa si comprende ancor meglio se si considera il dilemma posto classicamente dalla filosofia della mente:

- o la coscienza (in quanto sopravviene, cioè “si aggiunge” all’attività dei circuiti neurali) assolve una funzione, cioè ha un ruolo causale, che l’organismo/cervello senza di essa non assolverebbe [ma allora, in questa prospettiva definibile come dualistica, alcunché di “immateriale” interagirebbe con il cosmo fisico (come la res cogitans cartesiana attraverso la ghiandola pineale), in modo tale che in questo cosmo accadrebbero cose diverse da quelle che accadrebbero in assenza della coscienza medesima, e ne risulterebbe rotta la chiusura causale del mondo fisico (e sarebbe confutato il c.d. fisicalismo)];

- oppure la coscienza è un tratto free rider, una sorta di ombra che accompagna l’attività neurale, che non modifica in alcun modo il decorso degli eventi determinato da questa attività neurale [ma in questo caso la coscienza resterebbe del tutto gratuita ed essenzialmente inesplicata (cosa che appare davvero bizzarra, dato il carattere particolarissimo della coscienza)].

Come fanno gli autori dell’articolo in parola a dissolvere questo hard problem?

Essi rifiutano anche la prospettiva illusionistica (o eliminativistica) secondo la quale la coscienza è alcunché di illusorio e inesistente (cosa che ovviamente ripugna all’esperienza che ne abbiamo).

Essi, adottando un approccio essenzialmente monistico (per la precisione un dual aspect monism), negano (attraverso una complicata formalizzazione matematica che, tuttavia, non è strettamente necessaria per comprendere il cuore della loro argomentazione) che sia possibile che un sistema percettivo-cognitivo (identico a quello umano), descritto sotto il profilo esclusivamente neurocomputazionale, possa essere zombie, cioè “assolutamente” privo di coscienza.

La tesi fondamentale degli autori è la seguente:

A system either has or doesn’t have phenomenal consciousness with respect to some observer.

Un sistema percettivo-cognitivo appare privo di coscienza soltanto per un altro sistema percettivo-cognitivo, cioè all’interno di un sistema di riferimento centrato su questo secondo sistema,

esattamente come uno stesso corpo, in base alla teoria della relatività, può avere masse diverse (e anche essere caratterizzato da lunghezze spaziali differenti e intervalli temporali di differente durata) a seconda che lo si osservi dal suo punto di vista o da un punto di vista esterno.

In generale:

Phenomenal consciousness is neither private nor delusional, just relativistic. In the frame of reference of the cognitive system, it will be observable (first-person perspective) and in other frame of reference it will not (third-person perspective). These two cognitive frames of reference are both correct, just as in the case of an observer that claims to be at rest while another will claim that the observer has constant velocity. Given that consciousness is a relativistic phenomenon, neither observer position can be privileged, as they both describe the same underlying reality.

Questo stesso ragionamento porta a spiegare la ragione per la quale le “esperienze soggettive” sembrano avere carattere privato e incomunicabile (quello che percepisco io in questo momento, tu, che mi leggi, non lo percepisci; quanto meno non mai esattamente come lo percepisco io).

Ciò che io percepisco è un insieme di fenomeni mediati dal mio sistema percettivo-cognitivo che, nella mia prospettiva, si rende trasparente a se stesso (così come, se inforco occhiali adatti e ben puliti, posso vedere distintamente le cose che mi circondano senza vedere le lenti).

Philosophers refer to this feature of phenomenal consciousness as “transparency”: we seem to directly perceive things, rather than mental representations, even though mental representations mediate experience.

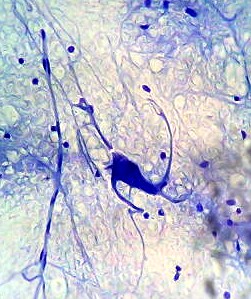

Ma se facciamo centro in un altro sistema percettivo-cognitivo (ad esempio nel tuo) ecco che il mio sistema percettivo-cognitivo appare come un intrico di reti neurali attraversato da scariche elettriche e flussi di neurotrasmettitori, senza che tu abbia alcuna percezione di ciò che io percepisco.

While Alice may observe herself feeling happiness as she’s looking at a rose, Bob will only measure patterns of neural activity. [Like in] the case of constant velocity, wherein Alice claims to be at rest while Bob is moving, while Bob claims that Alice is the one moving and that he is stationary. From Alice’s perspective, she has qualia and Bob only has patterns of neural activation, while from Bob’s perspective Alice just has patterns of neural activation while he has qualia.

Dunque non si ha mai un sistema percettivo-cognitivo che funziona come uno zombie, ma si ha sempre solo un sistema percettivo-cognitivo che è conscio di qualcos’altro; e questo qualcos’altro può anche essere un altro sistema percettivo-cognitivo che appare al primo sistema in modo diverso da come appare a se stesso; anzi, in quanto è trasparente a se stesso, in modo diverso da come non appare a se stesso.

Qualia and eidetic structures are not private and hence phenomenal consciousness is neither some mysterious force beyond the realm of science nor an irreducible element of reality. Rather, they appear to be private because in order to measure them, one needs to be in the appropriate frame of reference, viz., that of the cognitive system in question [...]. It is ultimately a question of causal power. Only from this frame of reference is there causal power for the representations in the dynamics of the system. Only from the frame of reference of the cognitive system are these neural patterns recognized as representations [...]. These representations are the input and output of the cognitive system [...]; they are the ones that cause the dynamics in this cognitive frame of reference. From outside that observer reference frame, as in the position the neuroscientist takes as a third-person observer, the same exact phenomena appear as neural computations. This is because the third-person perspective is constitutively outside of the dynamics of representations of the cognitive system in question, and hence these representations do not have any causal power over the neuroscientist

Gli autori giungono a definire un principio di equivalenza in base al quale “qualitative and quantitative aspects of consciousness are formally equivalent“, cioè la mia percezione p.e. di una mela rossa è sempre traducibile, mediante opportune trasformazioni, in un insieme di processi neurocomputazionali correlati a tale mia percezione (tali processi sarebbero nient’altro che questa stessa mia percezione così come appare non a me, ma a un altro che studia il mio cervello mentre io ho questa percezione).

In questa prospettiva, dunque, non si tratta di entità diverse: una materiale (il cervello) e l’altra immateriale (la coscienza) di cui occorra comprendere la relazione e, soprattutto, perché (hard problem) e come (easy problem) la prima generi la seconda (per assolvere quale funzione). Si tratta del medesimo sistema riguardato (cioè come appare) all’interno di sistemi di riferimento diversi (il proprio e un altro).

Questa prospettiva corrisponde, come gli stessi autori suggeriscono, a una prospettiva fenomenologica naturalizzata, come quella “sognata” ad es. da Francisco Varela (prima di morire): ciò che un (filosofo) fenomenologo individua come tratti caratteristici della coscienza che abbiamo del mondo (l’esempio che fanno gli autori, che evocano Husserl e Heidegger, riguarda il modo in cui facciamo esperienza del tempo) può essere “spiegato” anche in termini di funzionamento di strutture di tipo neurocomputazionale.

Questo progetto è senz’altro condivisibile, nella misura in cui non pretende di ridurre il lato fenomenologico al lato “meccanico”, ma, in un orizzonte monistico, li tiene insieme entrambi come aspetti di un tutto inscindibile.

Gli autori, infatti, si considerano giustamente fisicalisti, ma di un fisicalismo tuttavia allargato e non riduzionista. La coscienza non sarebbe illusoria (come per l’eliminativismo), ma sarebbe, per così dire, “l’altra faccia” dei sistemi fisici.

Physical patterns (e.g., of neural representations) and phenomenal properties (e.g., qualia) are two sides of the same coin.

Si sarebbe tentati, tuttavia, di trarre da questo approccio conclusioni piuttosto minimaliste: la coscienza potrebbe essere considerata, in questa prospettiva, un carattere in ultima analisi free rider, emergente in modo eccezionale e accidentale in condizioni molto particolari, all’interno di un universo prevalentemente meccanicistico, cieco e inconscio.

Proprio in quanto lo hard problem risulta dissolto pare che si debba rinunciare anche alla connessa ipotesi “panpsichistica” cara ad es. a Chalmers (cioè all’ipotesi che la coscienza sia qualcosa di “trascendente” che pervade l’universo, invocata come tale appunto in quanto inesplicabile fisicalisticamente).

Ma l’hard problem è davvero dissolto?

Si e no.

Certamente, gli autori, come altri prima di loro (Marco Giunti, ad esempio), hanno portato buoni argomenti contro l’ipotesi zombie, cioè che possano concettualmente esistere organismi viventi in tutto e per tutti simili a noi, ma privi di coscienza.

Tuttavia, resta la differenza tra a) sistemi di elaborazione di informazioni privi di coscienza, come ad es. una videocamera (che traduce informazioni tratte da onde luminose in informazioni registrate su supporto magnetico) o anche un organismo profondamente addormentato che, tuttavia, minimalmente, reagisce agli stimoli dell’ambiente, e b) sistemi di elaborazione di informazioni coscienti (sistemi cognitivi, nel linguaggio degli autori). Quando, come e perché in certi sistemi sorge la coscienza? Qui torniamo alle risposte classiche di Tononi, Baars etc. Ma, se queste possono, almeno a livello congetturale, risolvere lo easy problem (quale soglia deve essere superata, p.e. in termini di integrazione tra le informazioni, affinché si dia coscienza; o quali componenti del sistema nervoso centrale devono essere eccitati etc.), rimane il problema di capire perché le stesse funzioni assolte dalla coscienza non potrebbero essere assolte in assenza di essa.

Sotto questo profilo l’esistenza della coscienza, anche se considerata dagli autori un “non problema”, in quanto essa, all’interno del loro paradigma monistico, sarebbe “spontaneamente” parte di un sistema cognitivo, che evidentemente abbia raggiunto una certa complessità (senza che tale sistema possa operare in “modalità zombie“, cioè inconsciamente), resta nei fatti un problema, a meno che non ci si risolva, appunto, minimalisticamente, a considerarla un tratto free rider, privo di ruolo causale, accidentalmente associato a certi stati cerebrali.

Gli autori stessi sono consapevoli di questo problema, quando scrivono:

There are still several open questions that need to be addressed in the future. For example, what are the necessary and sufficient conditions for a cognitive frame of reference to have phenomenal consciousness?

Tuttavia, secondo me, l’intuizione degli autori, consistente nel considerare l’emergere della coscienza dal punto di vista relativistico, oltre a risolvere l’annosa questione del carattere privato della coscienza, ha il pregio di rimarcare il carattere che chiamerei trascendentale e, come tale, irriducibile della coscienza (gli autori, del resto, come detto, si proclamano fisicalisti, ma non riduzionisti).

Consideriamo la cosa sotto il seguente profilo. Tutto il ragionamento sviluppato dagli autori, come abbiamo visto, si regge sulla tesi ampiamente argomentata dell’impossibilità di sistemi zombie. Addirittura gli autori si spingono a sostenere che un sistema cognitivo artificiale (“ALICE”) in tutto e per tutto assimilabile per il suo funzionamento a un sistema naturale (“Alice”) dovrebbe essere altrettanto cosciente.

N. B. Quest’implicazione, astrattamente corretta, a me pare implausibile: un sistema artificiale, cioè non organico, potrebbe non avere un’organizzazione interna davvero assimilabile a un sistema vivente. Tuttavia, sono d’accordo con gli autori che, se un determinato sistema fosse del tutto equivalente a un sistema vivente cosciente, sarebbe un sistema vivente cosciente. Non è però scontato che sia sufficiente che l’equivalenza debba riguardare soltanto i due sistemi in quanto processano informazioni, come pensano gli autori quando sostengono che, senz’altro,

the neurocomputational structures are equivalent to the phenomenal structure.

Infatti, può darsi che la coscienza richieda altro rispetto a ciò che oggi comunemente associamo al termine “cognitivo” in senso funzionale (“neurocomputazionale”, nel lessico degli autori). Ma la questione qui può essere lasciata aperta, in quanto non è pertinente alle ragioni del mio interesse per la teoria degli autori.

La coscienza, dunque, in quanto caratteristica di ogni sistema percettvo-cognitivo propriamente detto (cioè tale da aver raggiunto, evidentemente, la sufficiente complessità), dovrebbe essere molto più diffusa di quello che si potrebbe credere (come argomentano, ad esempio, in modo convincente, Ginsburg e Jablonka, sulla base di un principio di analogia, in riferimento agli animali che consideriamo “inferiori”).

Ma, soprattutto, tutto il ragionamento poggia sul diverso modo in cui appaiono le cose (e, in particolare, i sistemi percettivo-cognitivi) a seconda che si adotti una prospettiva in prima persona (cioè a partire da un sistema percettivo-cognitivo trasparente a se stesso)…

the first-person perspective [...] is the cognitive system from its own observer perspective

… o una prospettiva in terza persona. Il “mio” sistema percettivo-cognitivo, che a me appare trasparente (cioè non appare affatto), ad altri può apparire come intrico di neuroni etc.

Quello che non è dato sapere è come siano le cose in se stesse. Quando gli autori invocano i diversi “sistemi di riferimento” di fatto invocano diverse “prospettive” cioè diverse forme della coscienza. Al di fuori di un sistema di riferimento (proprio o altrui), nella stessa logica degli autori, sembra difficile poter parlare di “universo” o di “realtà”

(come del resto accade anche se si adotta la prospettiva della relatività generale per la quale è necessario conoscere lo stato dell’osservatore, p.e. in quiete o in moto relativo, rispetto ai diversi sistemi fisici che osserva o in cui è immerso, per caratterizzare questi stessi sistemi fisici).

È vero che gli autori, dichiarandosi fisicalisti, precisano quanto segue:

We avoid the term “first-person perspective” because of its occasional association with immaterial views of consciousness; cognitive frames of reference refer to physical systems capable of representing and manipulating inputs. These systems have physical positions in space and time and instantiate distinct dynamics.

Tuttavia, nonostante queste avvertenze, va ricordato che per gli autori

a cognitive frame of reference [---] is the perspective of a specific cognitive system from which a set of physical objects and events are being measured

Ne segue che

- un sistema di riferimento cognitivo trasparente a se stesso (peraltro chiamato dagli autori anche “osservatore”) è esattamente una prospettiva in prima persona;

- il fatto che questo sistema abbia “una posizione fisica” nello spazio e nel tempo non comporta che tale posizione sia “assoluta”: spazio e tempo non possono che dipendere dallo stesso (o da un altro) sistema di riferimento (nulla, compresi spazio e tempo, è ciò che è assolutamente, ma ha certe proprietà solo a partire da un determinato sistema di riferimento / osservatore).

Del resto gli stessi autori dichiarano:

The essence of the relativistic principle is that there is nothing over and above the observer.

In definitiva l’invito (forse involontario) di questo articolo mi sembra sia quello di adottare una prospettiva radicalmente fenomenologica e di istituire relazioni (matematiche) tra fenomeni senza che vi sia alcuno spazio residuo per una pretesa “realtà in sé”. Se non è panpsichismo, è comunque una prospettiva in cui la coscienza (l’osservatore), nelle sue diverse manifestazioni (prospettive), appare imprescindibile.

N.B. Qualcuno potrebbe obiettare che “osservatore” o “sistema di riferimento”, nel lessico della relatività di Einstein, non implicano necessariamente la “coscienza” in senso fenomenologico. Ma, se questo è vero appunto nella fisica di Einstein, non è vero nella teoria relativistica della coscienza: infatti, la tesi degli autori è che un sistema percettivo-cognitivo, in quanto tale, è sempre anche “naturalmente” cosciente.

Si potrebbe, infatti, trarre la seguente conclusione: se, come gli autori suggeriscono, adottiamo una teoria relativistica della coscienza, cioè, in ultima analisi, consideriamo che gli stessi sistemi cognitivi di riferimento possono apparire o meno coscienti a seconda che siano osservati da se stessi o da altri, ciascun sistema cognitivo di riferimento è trasparente quanto meno a se stesso e, dunque, cosciente; non è dato, cioè, alcun sistema cognitivo di riferimento, rispetto al quale l’universo sia completamente privo di osservatori, in quanto ciascun sistema cognitivo di riferimento deve essere considerato sempre anche come un osservatore.

Alla luce di questo modello si potrebbe ad esempio risolvere l’annosa questione del sonno profondo. Quando dormo di sonno profondo agli occhi di altri, cioè all’interno di altri sistemi cognitivi di riferimento , io sono vivo, respiro e scorre del tempo. All’interno del mio sistema cognitivo di riferimento questo tempo, tuttavia, non esiste assolutamente. È saltato. Io mi addormento e mi risveglio senza soluzione di continuità, dal momento che un sistema cognitivo di riferimento trasparente a se stesso non può mai essere inconscio.

Che dire di quando morirò?

Qui si apre la classica alternativa: o non ci sarà risveglio, come nelle prospettive materialistiche à la Epicuro, oppure ve ne sarà uno altrove, come nelle prospettive soteriologiche à la Platone, legate o meno a dottrine trasmigrazioniste.

Curiosamente gli argomenti platonici a favore dell’immortalità dell’anima possono vantare la stessa matrice degli argomenti di Epicuro contro la paura della morte. Si tratta del teorema di Parmenide “Ciò che è è e non può non essere”, traducibile, nel lessico degli autori dell’articolo qui discusso, come: “Non si dà nessun sistema cognitivo di riferimento che non sia cosciente e trasparente a se stesso”.

Come è noto, nella Lettera a Meneceo Epicuro rassicura il suo corrispondente con l’osservazione: “Quando c’è la morte non ci siamo noi, quando ci siamo non c’è la morte”. Stranamente, però, Epicuro non ne deriva l’immortalità dell’anima, ma solo l’impossibilità di fare esperienza del passaggio dalla vita alla morte (proprio come non si può fare esperienza del passaggio dalla veglia al sonno).

Viceversa, nel Fedone, Platone, deriva dalla nozione di “anima” come sostanza contraddistinta dalla proprietà dell’esser viva (noi diremmo: di esserci) l’impossibilità (la contraddittorietà) per l’anima dell’esser morta.

Chi ha ragione?